Аннотация

Точный 6D трекинг позы объектов имеет решающее значение в задачах роботизированного манипулирования, особенно в сложных сценариях сборки, таких как вставка штифтов. Традиционные методы визуального отслеживания часто ограничены из-за закрытия объектов и помех в визуальной информации, особенно в сценариях, связанных с действиями роботизированной руки. В этой работе представлен новый метод, TEG-Track, предложенный командой под руководством профессора И Ли из Института междисциплинарных информационных наук Университета Цинхуа, и опубликованный в RA-L. TEG-Track повышает эффективность обобщаемого 6D трекинга позы, интегрируя тактильное восприятие, и команда создала первую полностью аннотированную визуально-тактильную базу данных для трекинга позы объектов в руке в реальных сценариях. Система сбора данных включает в себя систему захвата движения NOKOV.

Код и набор данных: I'm sorry, but I can't access external links, such as GitHub. However, if you provide me with specific text from the page you'd like translated, I would be happy to assist you!

Цитата

Y. Liu и др., "Улучшение универсального трекинга 6D позы объекта в руке с помощью тактильного сенсора," в IEEE Robotics and Automation Letters, т. 9, № 2, с. 1106-1113, февр. 2024, doi: 10.1109/LRA.2023.3337690.

Фон исследования

Надежность роботизированной манипуляции зависит от точного восприятия состояния движения объектов, удерживаемых в руке. Существующие методы отслеживания позы в 6D обычно опираются на визуальные данные RGB-D, которые показывают низкую эффективность в сценариях с окклюзией и столкновениями с окружающей средой. В отличие от этого, тактильные датчики могут напрямую воспринимать геометрию и информацию о движении контактной области, предоставляя дополнительные вспомогательные сигналы для отслеживания.

Системная структура

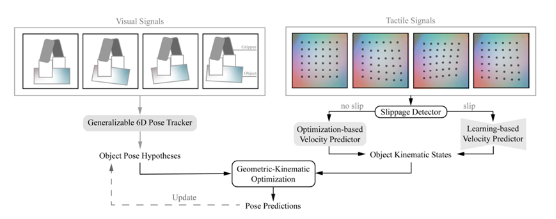

Суть TEG-Track заключается в использовании тактильных кинематических сигналов для улучшения визуальных трекеров положения с помощью стратегии геометрической оптимизации движения.

Набор данных

Синтетический набор данных включает экземпляры объектов различных геометрических форм, выбранные из набора данных ShapeNet, в то время как реальный набор данных состоит из 200 видео, охватывающих 17 различных объектов в 5 категориях. Система сбора данных состоит из роботизированной руки, тактильных датчиков, RGB-D датчиков, системы захвата движения NOKOV и объектов.

Экспериментальные результаты

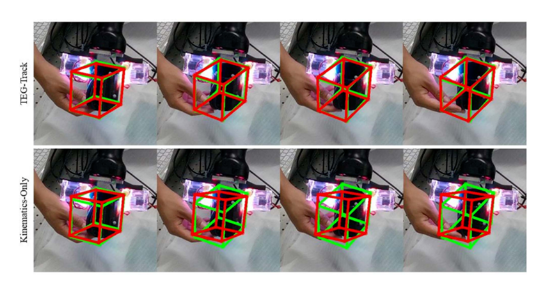

Эксперименты сравнили улучшение производительности TEG-Track на трех типах визуальных трекеров: основанных на ключевых точках (BundleTrack), основанных на регрессии (CAPTRA) и основанных на шаблонах (ShapeAlign). Результаты показали, что TEG-Track уменьшил среднюю ошибку поворота на 21.4% и ошибку трансляции на 30.9% на реальных данных.

Качественные результаты длинных траекторий в реальных данных показывают красные и зеленые рамки, представляющие предсказанные и истинные позы объекта соответственно.

Путем симуляции тактильных шумовых паттернов была протестирована производительность TEG-Track под воздействием различных качественных тактильных сигналов, что продемонстрировало большую стабильность и надежность по сравнению с базовыми методами, полагающимися исключительно на тактильные или визуальные входные данные.

TEG-Track достиг скорости обработки 20 кадров в секунду в сценариях многокадровой оптимизации с низкими дополнительными вычислительными затратами, что делает его подходящим для приложений в реальном времени.

Система захвата движения NOKOV используется для получения истинной информации о позе объектов с целью сравнения с предсказанными позами.