В области исследований многороботных систем контроль окружения является одной из основных тем. Он находит широкое применение как в гражданских, так и в военных сферах, включая совместное сопровождение, захват вражеских целей, разведывательное наблюдение, патрулирование безэкипажными надводными судами и охоту, среди прочего.

Основная задача в этих приложениях заключается в том, как управлять многорукой системой, включающей распределение по нескольким целям, одновременно решая проблемы окружения цели и предотвращения столкновений. Это представляет собой значительную проблему, особенно для децентрализованных многоруких систем.

Команда профессора Пу Чжи Цзяна из Института автоматизации Китайской академии наук представила статью на конференции ICRA 2022. Они предложили метод глубокого обучения с подкреплением, основанный на графе отношений, продемонстрировав хорошую адаптивность к задаче многократного окружения с учетом избегания столкновений (MECA) при различных условиях.

ieeexplore

Формулировка проблемы

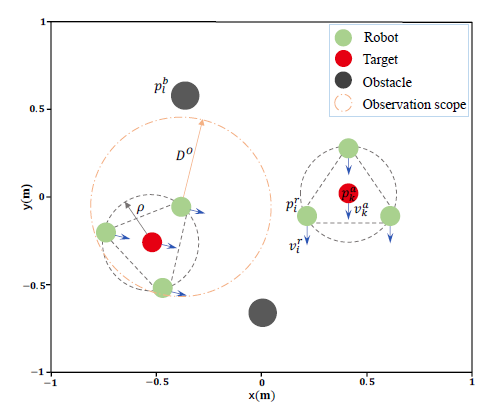

Исследовательское изучение определяет задачу MECA, в которой среда с L статическими препятствиями (черные круги) включает многороботную систему, состоящую из N роботов (зеленые круги). Цель состоит в том, чтобы совместно окружить K (1 < K < N) неподвижные или движущиеся цели (красные круги).

Все роботы должны автономно образовывать несколько групп, чтобы окружить все цели. Каждой группе необходимо сформировать круговую формацию, чтобы окружить отдельную цель, избегая столкновений. Это включает в себя решение следующих трех подзадач:

Динамическое многопрофильное распределение и группировка

2) Окружение целей каждой группой

3) Избежание столкновений между группами

Иллюстрация MECA для децентрализованной многороботной системы

Метод

В контексте проблемы MECA существует три типа сущностей: роботы, цели и препятствия. Разные сущности имеют различные взаимосвязи с роботами, такие как избегание препятствий, окружение целей и сотрудничество с другими роботами.

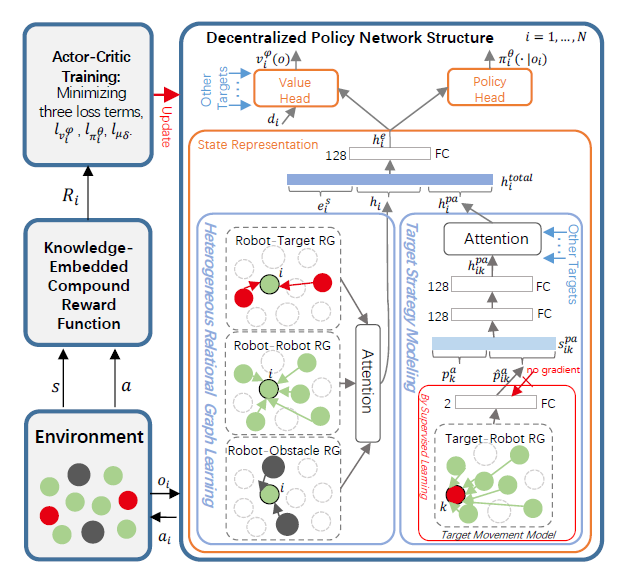

Исследование предлагает децентрализованный подход глубокого обучения с подкреплением (Deep Reinforcement Learning, DRL), основанный на графах отношений (Relationship Graphs, RGs) на уровне робота и уровне цели, названный методом MECA-DRL-RG.

Конкретно:

1. Используйте графовые сети с вниманием (GAT) для моделирования и обучения графам взаимосвязей на уровне робота. Эти графы взаимосвязей состоят из трех гетерогенных графов отношений между каждым роботом и другими роботами, целями и препятствиями.

2. Используйте GAT для построения целевых RG, захватывающих пространственные отношения между роботами и различными целями. Движение целей моделируется с помощью целевого RG и изучается через контролируемое обучение для предсказания траекторий целей.

3. Кроме того, определяется функция вознаграждения с учетом знаний, чтобы решить проблему многократных целей в MECA. Используются алгоритмы обучения Actor-Critic, основанные на централизованных обучающих и децентрализованных исполнительных структурах, для обучения сети политики.

Общая структура MECA-DRL-RG

Эксперимент

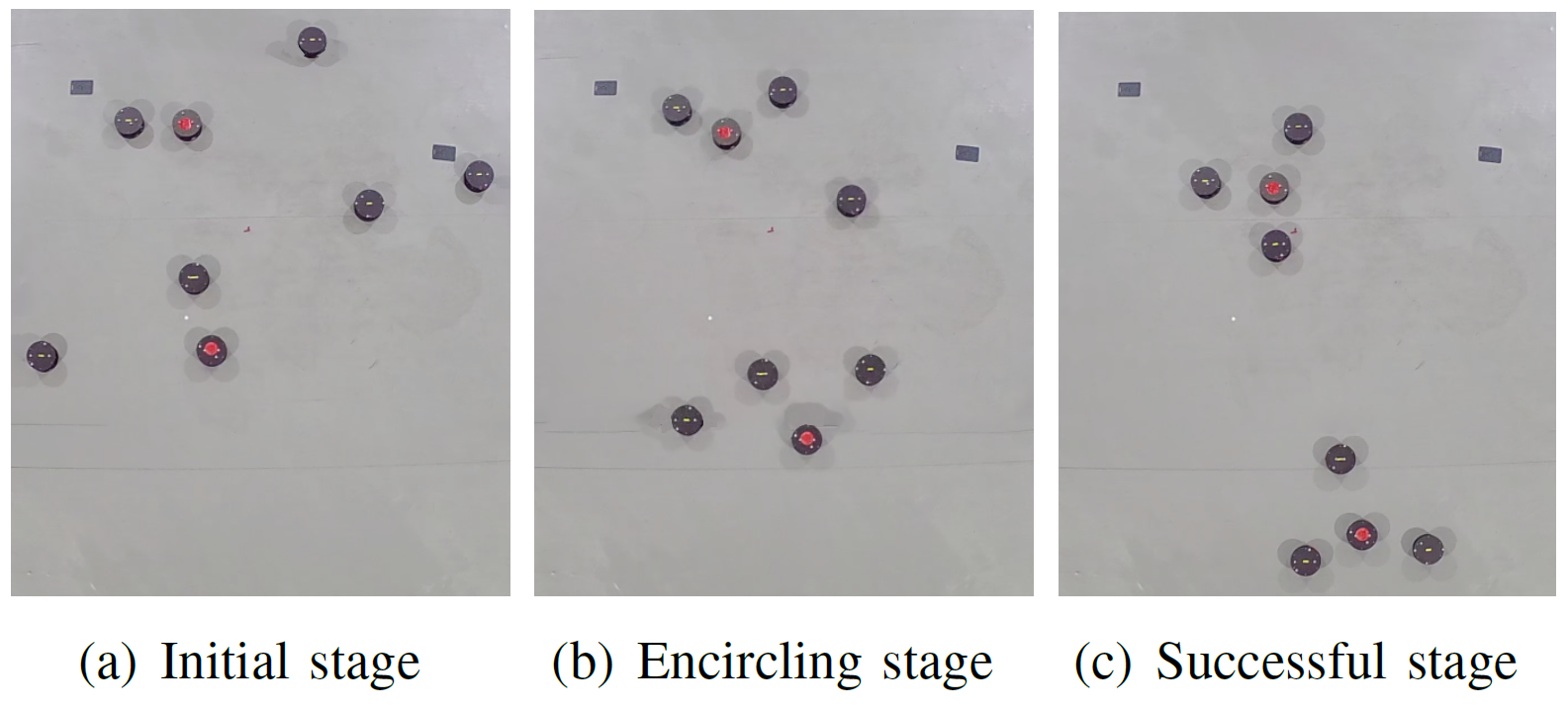

Исследовательская группа провела как симуляционные эксперименты, так и эксперименты в реальной среде. В реальном эксперименте сценарий был установлен следующим образом: 6 роботов окружали 2 движущиеся цели в среде с 2 препятствиями. Позиционные и скоростные данные роботов были записаны системой захвата движения NOKOV.

Снимки 6 роботов, окружающих 2 цели в среде с 2 препятствиями

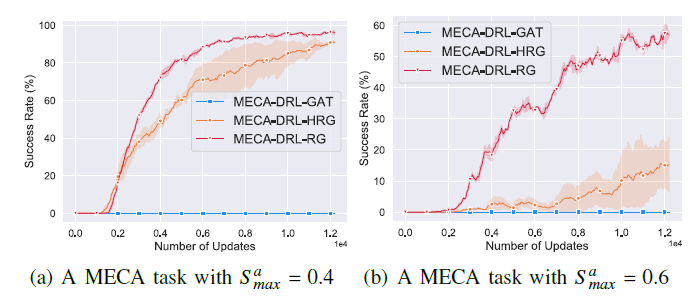

Как симуляционные, так и реальные эксперименты подтвердили, что по сравнению с другими методами, подход MECA-DRL-RG позволяет роботам обучаться гетерогенным графам пространственных отношений из окружающей среды. Это позволяет им предсказывать траектории целей, тем самым улучшая понимание и предсказание окружающей среды каждым роботом. Эффективность метода MECA-DRL-RG была подтверждена.

Более того, независимо от увеличения числа роботов, препятствий или целей, а также от ускорения скорости движения цели, метод MECA-DRL-RG продемонстрировал отличные результаты и широкую адаптивность.

Кривые обучения MECA-DRL-RG

Библиография: