В области роботизированного обучения с подкреплением проблема передачи данных из симуляции в реальность является постоянной проблемой при обучении и развертывании алгоритмов, особенно для задач, требующих больших объемов данных, таких как координированное управление крупномасштабными роями дронов. Исследовательская группа из Университета Бэйхан представила платформу Air-M в этой статье, которая устанавливает соответствие между реальным миром и симуляционной средой с использованием системы захвата движения NOKOV. Это позволяет реальным дронам взаимодействовать с виртуальными объектами через виртуальные сенсоры, что позволяет обучать политику сети с использованием виртуальных агентов и бесшовно передавать ее на реальные дроны. Исследование показывает, что платформа Air-M превосходит существующие технологии по эффективности обучения и переносимости, что делает её многообещающей платформой для применения роеобразных дронов.

ЦитатаJ. Lou, W. Wu, S. Liao и R. Shi, "Air-M: Визуальная платформа множественного агентов для обучения с подкреплением в крупномасштабных воздушных беспилотных системах," 2023 IEEE/RSJ Международная конференция по интеллектуальным роботам и системам (IROS), Детройт, штат Мичиган, США, 2023, стр. 5598-5605, doi: 10.1109/IROS55552.2023.10341405.

Схема платформы

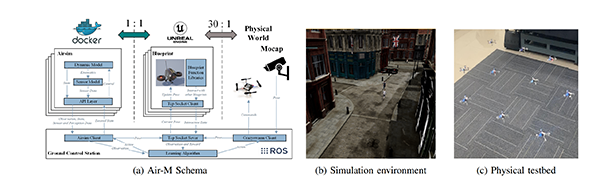

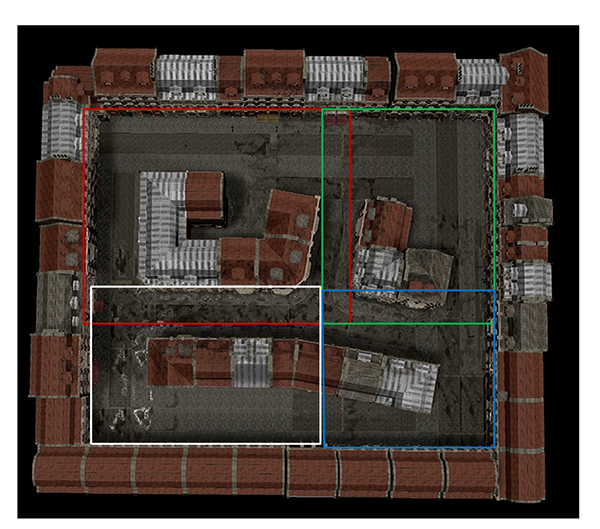

Схема Air-M, а также среда моделирования и физическая испытательная площадка, проиллюстрированы на следующей диаграмме.

Основные компоненты Air-M: (a) контейнер AirSim, который предоставляет кинематические и динамические модели, а также данные сенсоров; (b) функции чертежа, которые предлагают структуру связи между агентами; и (c) маркерные точки, обнаруженные системой захвата движения, обеспечивают отображение реального мира в симуляционную среду.

A. Контейнеризация AirSim

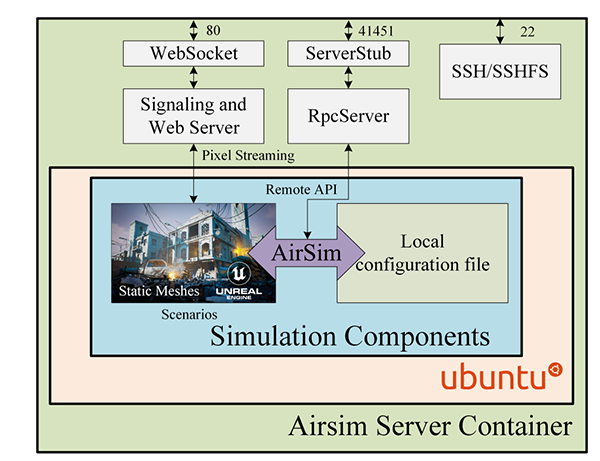

Команда исследователей использовала Docker для инкапсуляции сервера AirSim и его зависимостей, а затем упаковала их в образ. Кроме того, мы сохраняем статические сетки различных сценариев и компилируем их в не редактируемые исполняемые файлы в качестве фоновых окружений. Когда пользователь запускает контейнер, AirSim загружает локальный файл настроек для генерации дронов заданного количества, открывает порты и предоставляет услуги.

Контейнер AirSim, который может выбирать различные сценарии и конфигурационные файлы для предоставления RPC-серверов и PixelStreaming.

B. Взаимодействие и коммуникация в Unreal Engine Blueprint

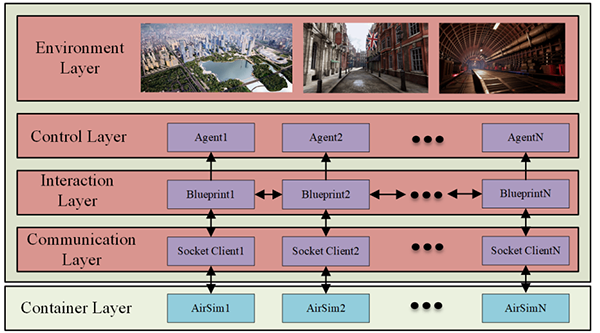

Транспортные средства внутри контейнера AirSim сопоставлены с общей симуляционной средой при условии, что они могут взаимодействовать с этими объектами в пределах ограниченного радиуса. Механизмы взаимодействия и связи реализованы с помощью чертежей UE4.

Визуализация контейнера AirSim и механизмов взаимодействия коммуникации между агентами.

C. Физическая экспериментальная испытательная платформа

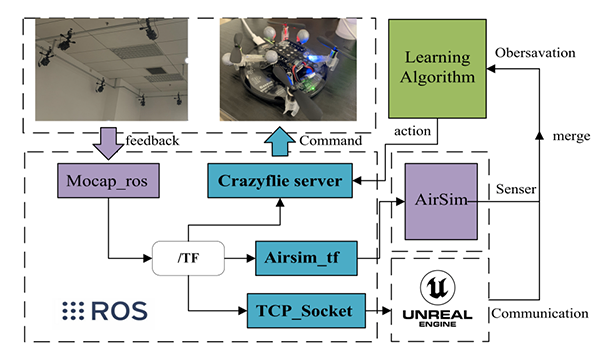

Исследовательская группа создала внутреннюю испытательную площадку размером 3x1 метр, пропорционально отображённую в системе моделирования. Система захвата движения NOKOV предоставляет обратную связь о движении, позволяя смоделированным дронам корректировать свои позиции на основе собранных данных, тем самым способствуя оценке алгоритмов обучения с подкреплением.

Физическая экспериментальная платформа, она содержит внешнюю систему позиционирования, систему управления БПЛА и онтологию БПЛА.

Экспериментальные демонстрации

Чтобы продемонстрировать универсальность платформы Air-M, исследовательская группа отметила ее преимущества в алгоритмах обучения дронов с помощью двух исчерпывающих примеров тренировки.

Задача первая: Учимся искать

Цель состоит в том, чтобы обучить рой дронов находить толпы на городских улицах. Дроны обучаются в оффлайне с использованием централизованной информации, но выполняют задачу в децентрализованном режиме онлайн. Этот пример демонстрирует координированное поведение обученного роя дронов.

Сценарий для обучения кооперативному поиску, четыре БПЛА создаются в центре, а соответствующиеmission области приблизительно размещены заранее.

Задание два: Игра на захват

Цель состоит в том, чтобы с помощью 20 обученных синих дронов найти и захватить 20 красных дронов в течение определенного времени. При обнаружении цели дрон сообщает о ее местоположении в командный центр, переключается на алгоритм отслеживания и вызывает ближайших союзников для согласованного захвата.

Система захвата движения NOKOV предоставляет обратную связь о движении, позволяя реальным дронам взаимодействовать с виртуальными датчиками и объектами, тем самым способствуя исследованию обучения с подкреплением дронов в крупном масштабе.

Информация об авторе

Дзябин Лоу: аспирант Школы компьютерных наук университета Бейханг. Исследовательские интересы включают в себя рои́нтеллект, многоагентное обучение с подкреплением и ройробототехнику.

Вэньцзюн У: профессор и научный руководитель аспирантов в Университете Бэйхань. Научные интересы охватывают swarm intelligence и многоагентные системы, когнитивное моделирование и интеллектуальное обучение, интеллектуальные облачные сервисы и интеллектуальную инженерную разработку программного обеспечения.

Шухао Ляо: кандидат наук в Школе компьютерных наук Университета Бейхан. Научные интересы включают многопользовательское обучение с подкреплением и большие модели.

Ронгье Ши (Автор для переписки): доцент в Университете Бейхань. Научные интересы включают машинное обучение, обучение с подкреплением, многоагентные системы и их применение в умных городах и интеллектуальных транспортных системах.